"한빛미디어 서평단 <나는리뷰어다> 활동을 위해서 책을 협찬 받아 작성된 서평입니다."

정말 고맙게도 2026년 서평단에 또 선발되었다. `한빛미디어` 정말 사랑해요 !!! 😍

하지만, 개인적으로 조금 아쉬운 점은 올해 부터는 종이책이 아니라 전자책(이북)으로 책을 제공받는다.

쌓여가는 책들을 바라보는 것이 나의 행복이었는데 ... 😥

그래도 우수리뷰어로 3번 선발되면 종이책을 받을 수 있다니까, 열심히 해봐야겠다 !!! 😁

이번에 살펴볼 책은 "누구나 아는 나만 모르는 제미나이" 이다.

이북이다보니 모니터 화면으로 책 표지를 찍어어야 했다 😅

사실 책 표지가 개인적인 취향이 아니었지만(좀 더 예쁘게 만들어주시지 😋),

간만에 정말 보기 편한 내 입맛에 딱 맞는 책이었다. 그런데 !!!

이 책이 가장 마음에 드는 이유가 설마, 내 나이가 ... 내 나이가 ... 이런 ... 흑 ... 흑 ... 😥

그렇지만, 이 부분을 보고 오해를 하면 안된다 !!!

큰 부담없이 편하게 볼 수 있는 접근성이 좋은 책이라는 이야기이지, 나이든 사람만을 위한 책이라는 말이 아니다 !!!

책 제목 부분을 잘 살펴보면 보일텐데 "누", "나"라는 부분이 부각되어 있다.

이 책의 저자가 바로 57만 구독자를 갖고 있는 유튜버 "누나IT" 이다. 나도 오며 가며 여러번 봤던 컨텐츠의 주인공이라니...

IT유투버이니만큼 이 책과 관련해서도 컨텐츠를 제공해주고 있다.

- https://www.youtube.com/playlist?list=PLBkBo__arIECXOtt1EK7NkzZ7Ga9aQvQn

그런데, 사람들에 따라서 "어?! 나는 ChatGPT 쓰니까 굳이 제미나이까지 살펴봐야 하나?"라는 식으로 생각할 수도 있다.

제미나이 외에도 ChatGPT를 비롯해서 Claude라던지, Perplexity라던지 다른 AI 도구들을 많이 사용할테니 말이다.

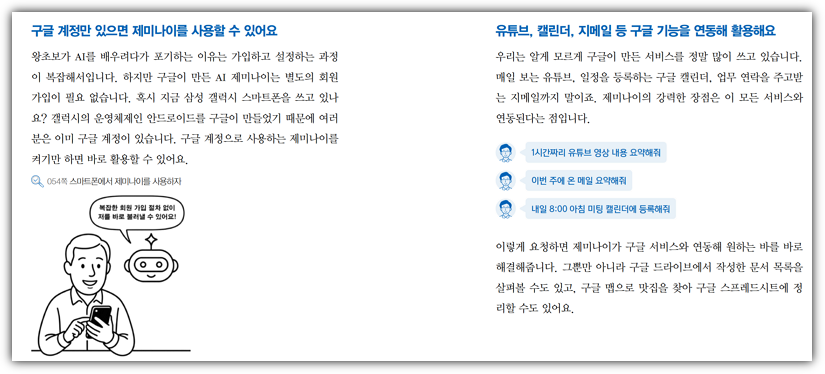

하지만, 제미나이는 무려 우리 구글님이 제공해주는 도구이다.

다른 도구들을 사용하더라도 편하게 접근할 수 있도록 무료 등급으로도 큰 불편함 없이 사용할 수 있고,

유튜브, 캘린더, 지메일 등의 온갖 구글 생태계에 있는 도구들과의 연계성이 정말 훌륭하기에 사용할만한 가치가 있다.

사실 나는 이미 구글을 PRO 등급으로 사용하고 있다.

하지만, 그냥 대화방 수준으로만 사용하고 있을 뿐이었다.

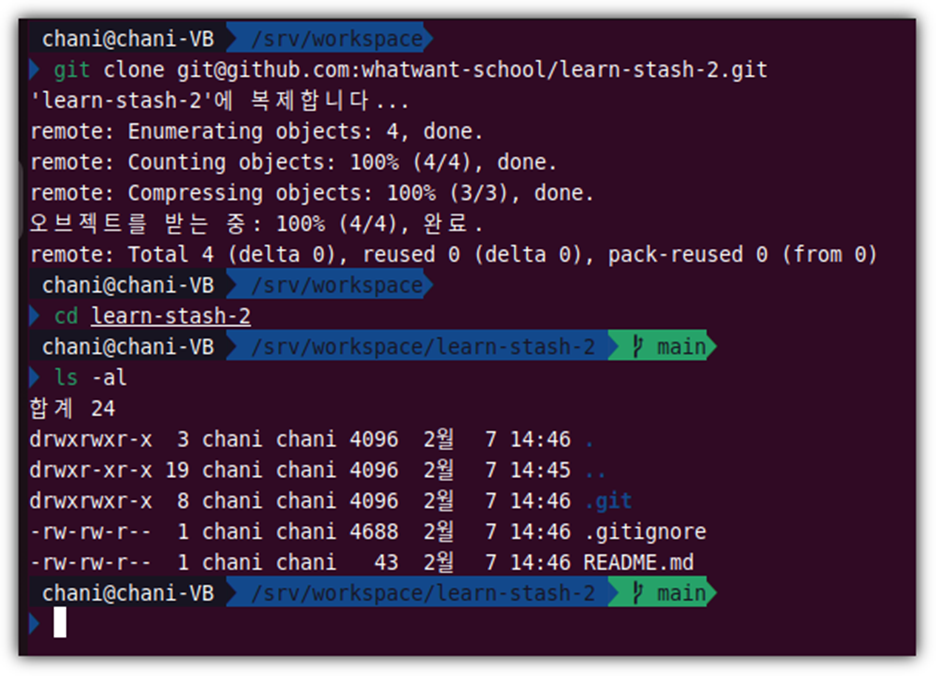

이 책을 보면서 배운 것이 정말 많은데,

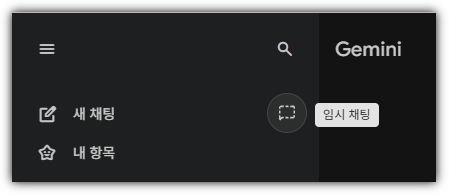

만날 보면서도 이게 뭔지 몰랐던 ... `임시 채팅` 버튼을 이번에 처음 알게 되었다.

민감한 정보를 다룰 때, 학습에 사용되지 않으면서 자동으로 삭제되는 채팅 세션이란다.

그렇다. 사람은 배워야 한다. 🙄 (매뉴얼을 무시하면 안된다. 차근 차근 배워야 한다!)

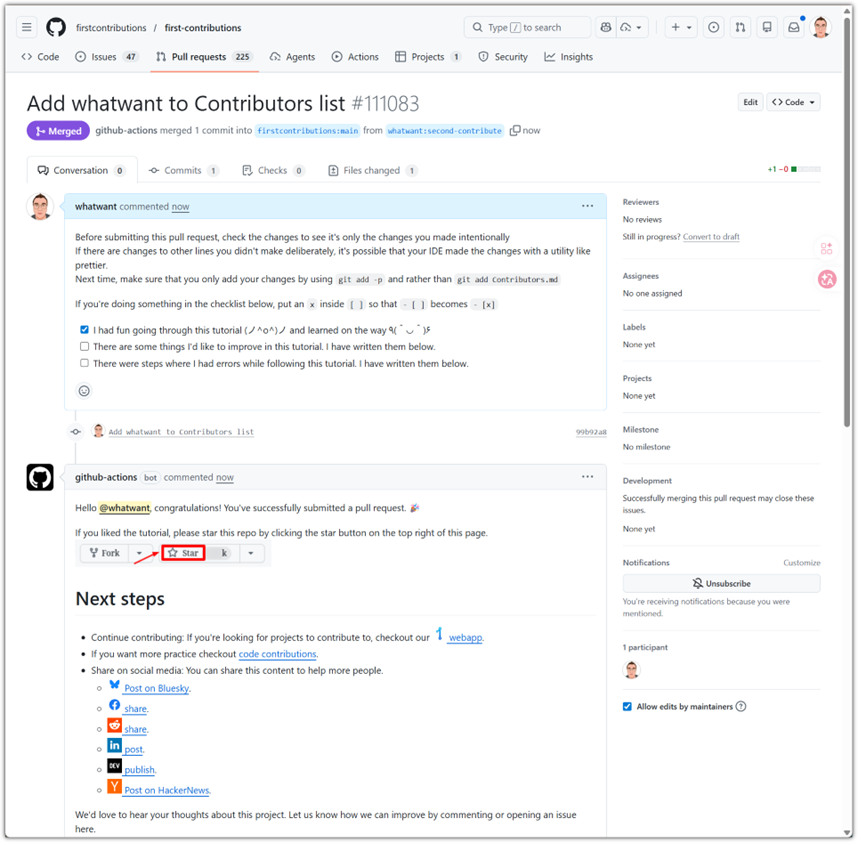

다만, 이 책을 보면서 책이 나온지 얼마 되지 않았는데 벌써 UI가 달라져 버려서 마음이 아팠다.

AI 세계는 정말 너무 빨리 변한다. 쫒아가기에 버겁다.

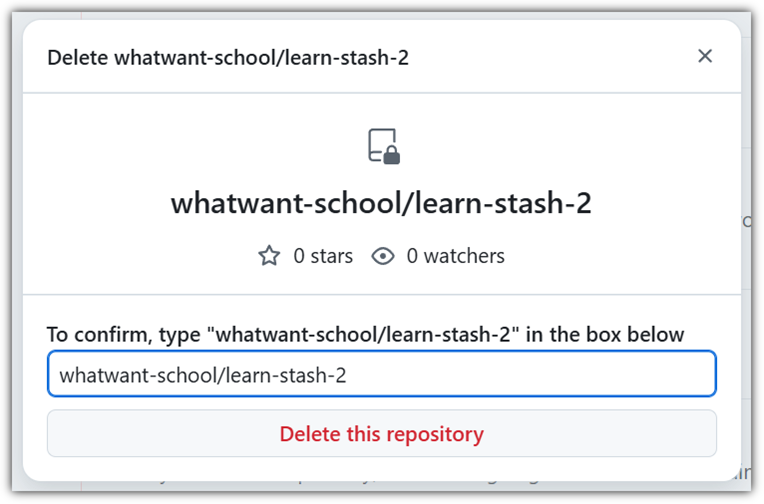

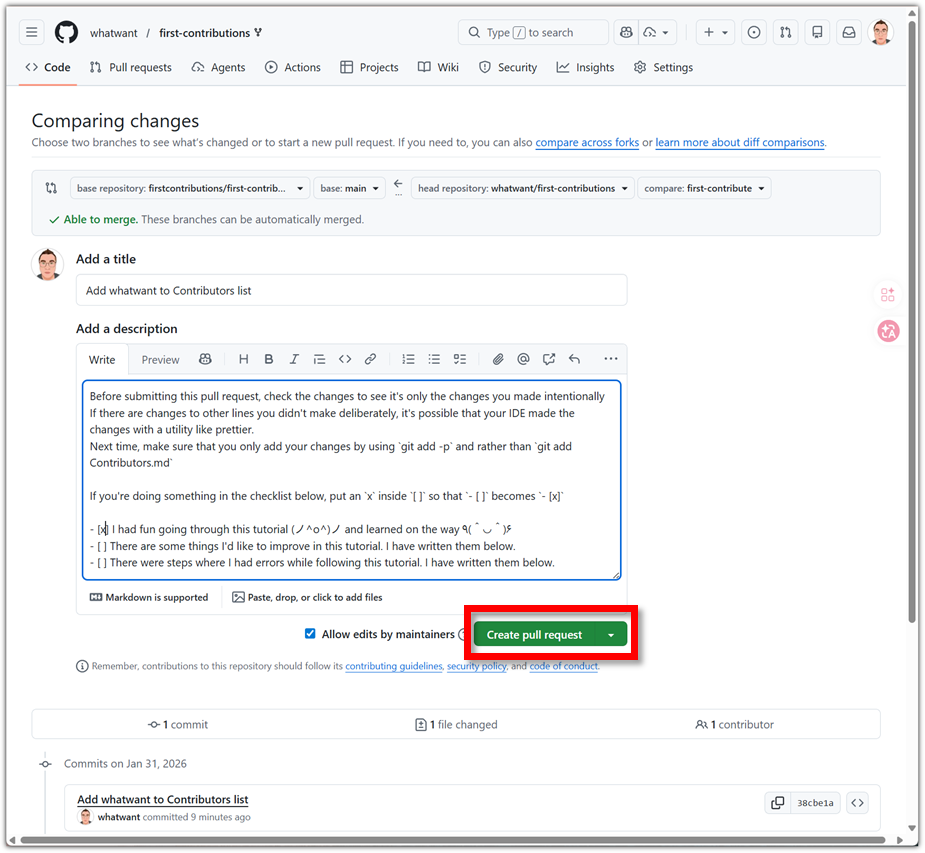

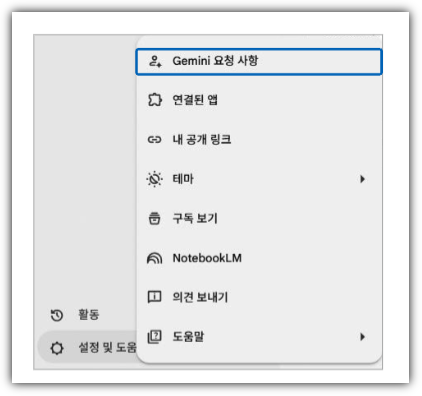

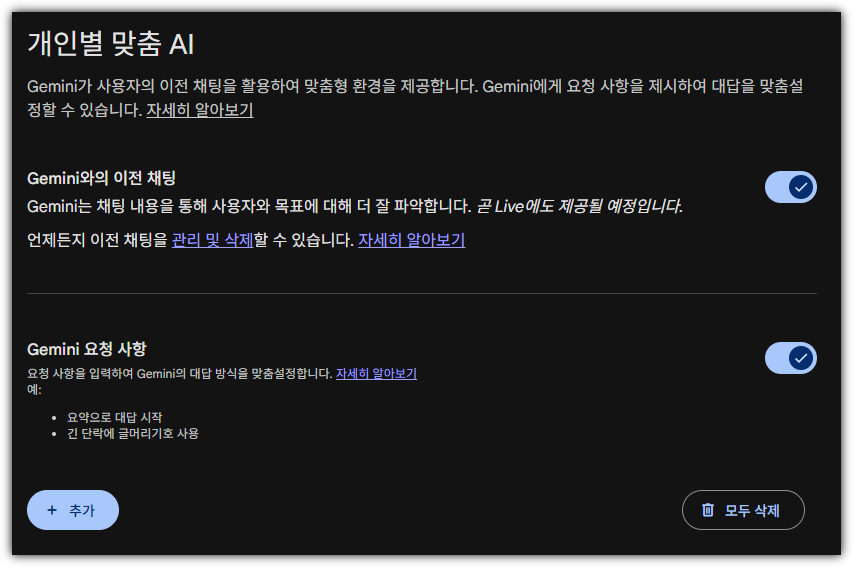

책에서는 이렇게 안내를 해주셨다.

그런데, 실제 따라해보려 했더니 메뉴 위치가 바뀐 것이다.

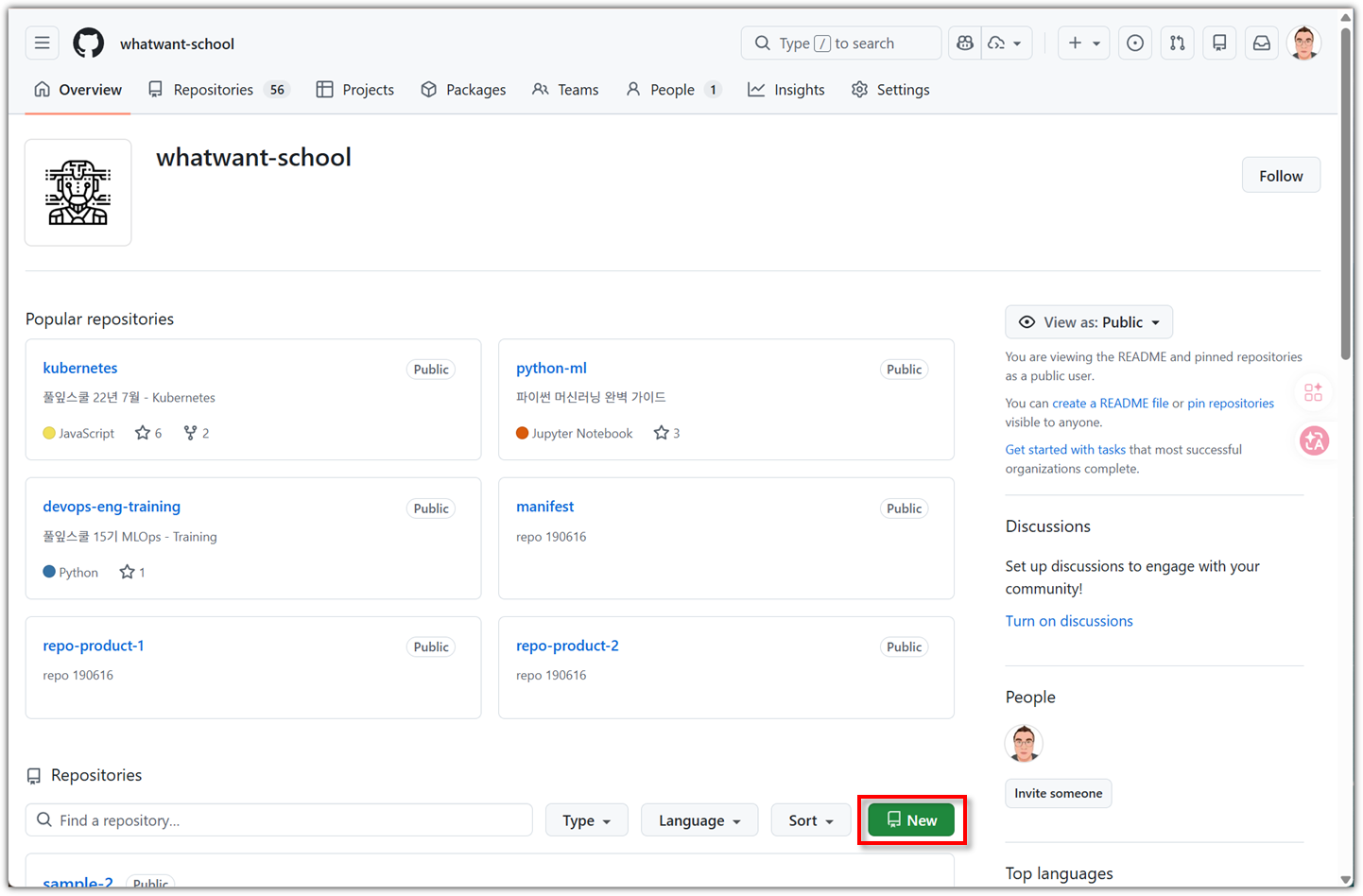

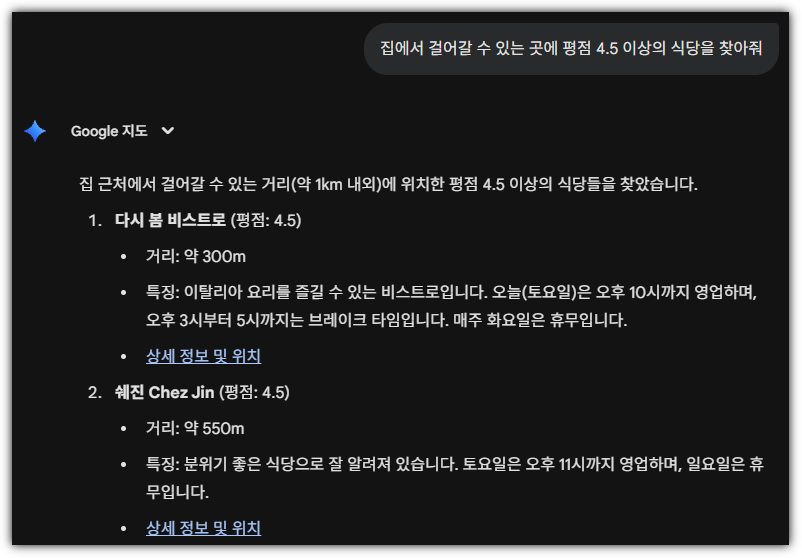

그리고, 책에서 `Google Maps` 연결해서 "평점 4.5 이상 설렁탕 맛집 추천"을 할 수 있다고 해서

오늘 점심 먹을 식당을 찾아보려고 했는데,

안타깝게도 요즘 Google과 우리나라 지도 반출 문제로 시끄럽더니,

연결된 앱에서 `Google Maps` 항목을 찾을 수가 없었다.

어?! 그런데, 딱히 앱을 연결하지 않아도 된다 !!!

그냥 채팅창에서 프롬프트를 넣으니 그냥 된다.

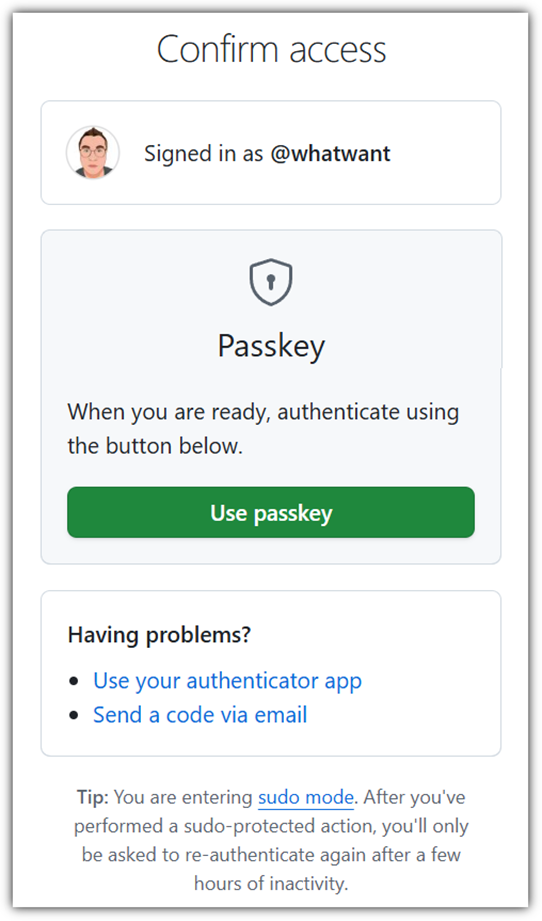

그리고, AI Studio에서도 UI가 좀 바뀌었다.

Playground를 클릭하고 바로 Audio를 선택하면 된다고 나와있지만,

지금의 AI Studio에서는 오른쪽에 보이는 모델 부분을 클릭해야 한다.

그러면 Audio 관련 모델을 선택할 수 있도록 나온다.

이렇게 변경된 부분들이 있다고 해서 책의 가치가 떨어지는 것은 절대 아니다.

메뉴의 위치나 사용법이 약간 바뀌었을 뿐이지,

Gemini, Veo, AI Studio, Mix Board 등의 여러 구글 AI 도구들을 이용해서

무엇을 할 수 있고 어떻게 해야하는지에 대한 부분은 여전히 유효하면서 유용하다.

거의 매뉴얼 수준으로 Gemini의 각 기능을 설명해주고

보면서 그냥 그대로 따라하면 되는 수준으로 사용법을 설명해주고

유튜브 영상을 통해 보충 수업까지 해주는 정말 편하게 공부할 수 있는 훌륭한 책이다.

Gemini에 대해서 대화방처럼만 사용해본 사람들이라면

그리고 Google 생태계에 있는 도구나 서비스들을 사용하고 있는 사람이라면

이 책을 통해서 AI를 이용해 얼마나 편해질 수 있는지, 역량향상을 할 수 있는지 경험해보기 바란다.

'Books' 카테고리의 다른 글

| [한빛미디어] 일 잘하는 사람은 이렇게 챗GPT를 씁니다 (0) | 2025.12.28 |

|---|---|

| [한빛미디어] 바이브 코딩 너머 개발자 생존법 (1) | 2025.11.23 |

| [길벗출판사] 밑바닥부터 만들면서 배우는 LLM (0) | 2025.11.22 |

| [한빛미디어] 할루시네이션을 줄여주는 프롬프트 엔지니어링 (0) | 2025.10.28 |

| [한빛미디어] 정지훈의 양자 컴퓨터 강의 (2) | 2025.09.28 |