관심 있는 책들을 가지고 혼공 활동을 열심히 했더니,

참여할만한 것들이 없어서 쉬었던 혼공학습단 활동을 간만에 하게 되었다.

바로 이 책이 나왔기 때문이다.

- https://www.whatwant.com/entry/honman-deep

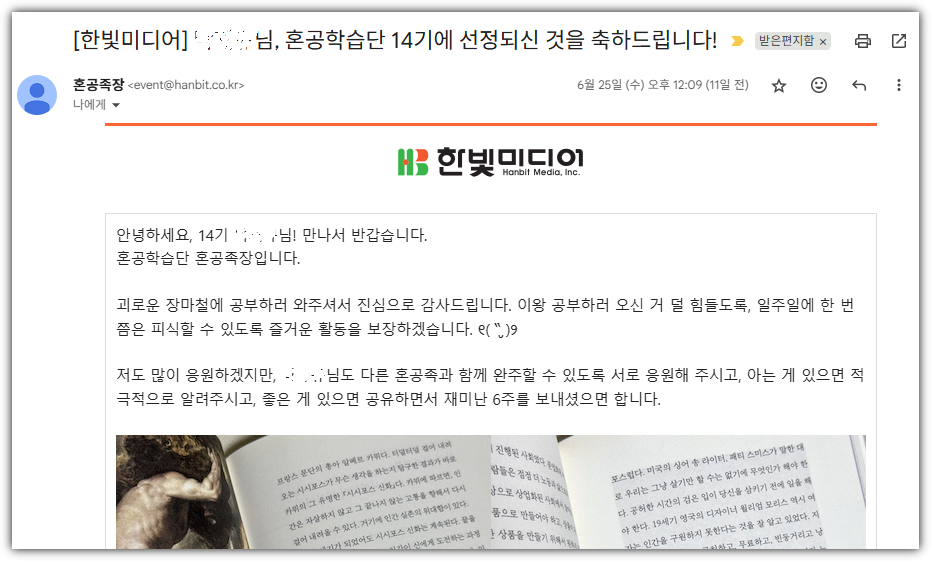

그래서, 이번 혼공학습단 14기에 지원하게 되었고,

기쁘게도 선정이 되었다.

앞으로도 계속 "만들면서" 시리즈가 나왔으면 좋겠다.

- https://hongong.hanbit.co.kr/

혼공시리즈이기에 너무나 고맙게도 동영상을 비롯해 소스코드까지 모두 제공해준다.

- https://www.youtube.com/playlist?list=PLVsNizTWUw7F1EIzSwUiPn3PFSO-aSEHi

박해선님은 나를 모르겠지만,

나는 박해선님을 애정한다 !!! ^^

- https://github.com/rickiepark

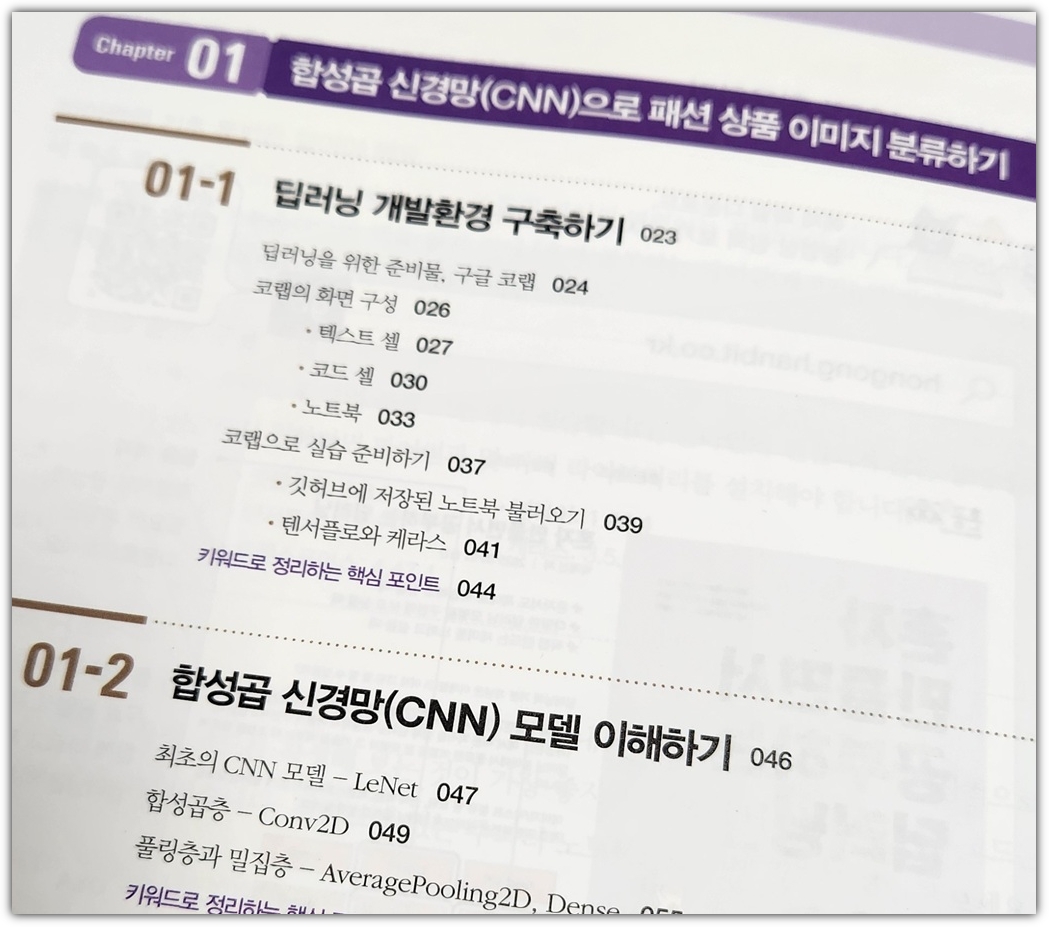

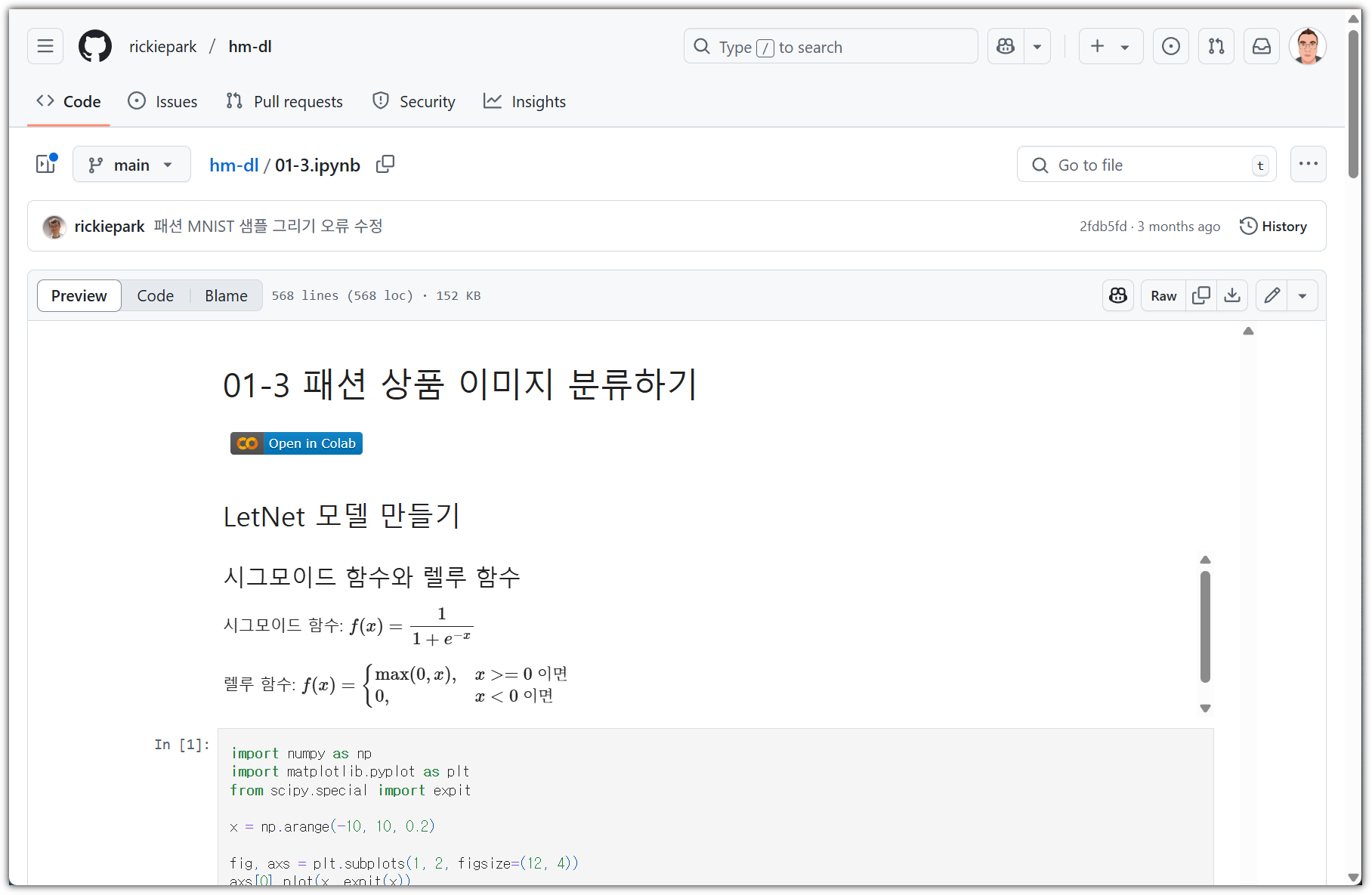

이번 첫 주 공부할 거리는 다음과 같다.

▷ 기본 숙제

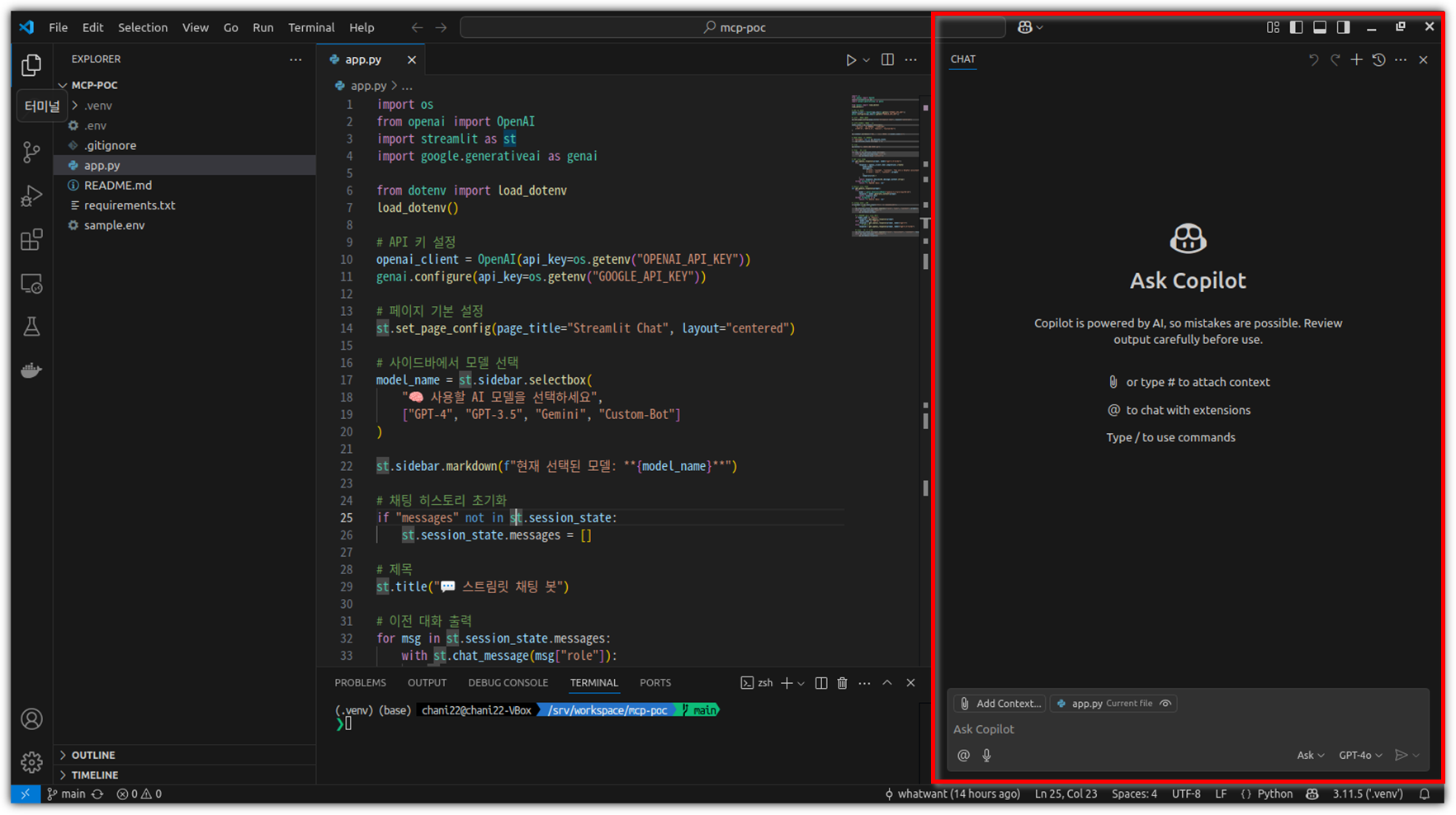

- 소스코드 확인하기

. https://github.com/rickiepark/hm-dl

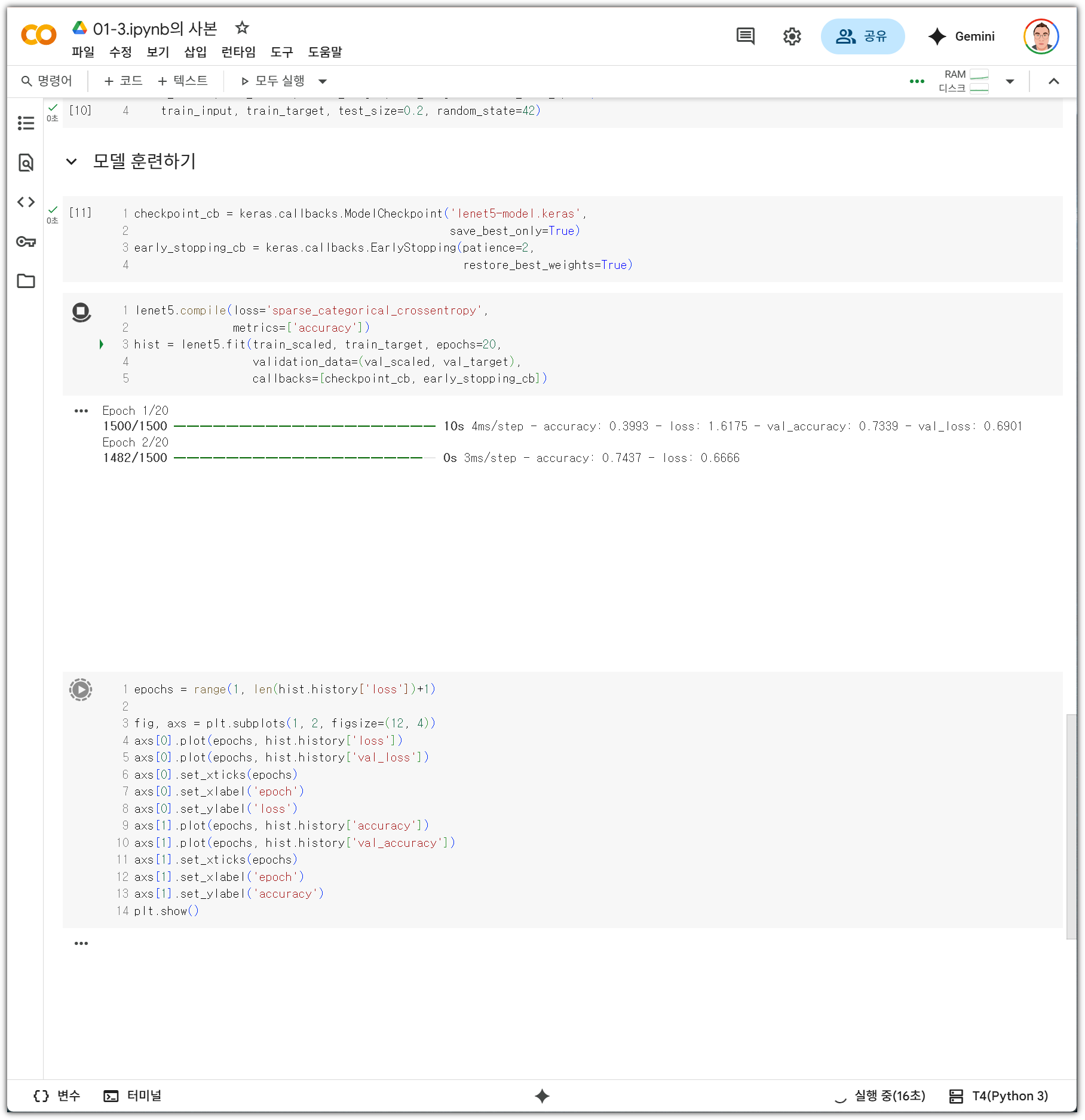

- '01-3.ipynb' 파일 확인

. https://github.com/rickiepark/hm-dl/blob/main/01-3.ipynb

- 'Open in Colab' 클릭

. 'Drive에 사본 저장'까지 진행

- 모두 실행

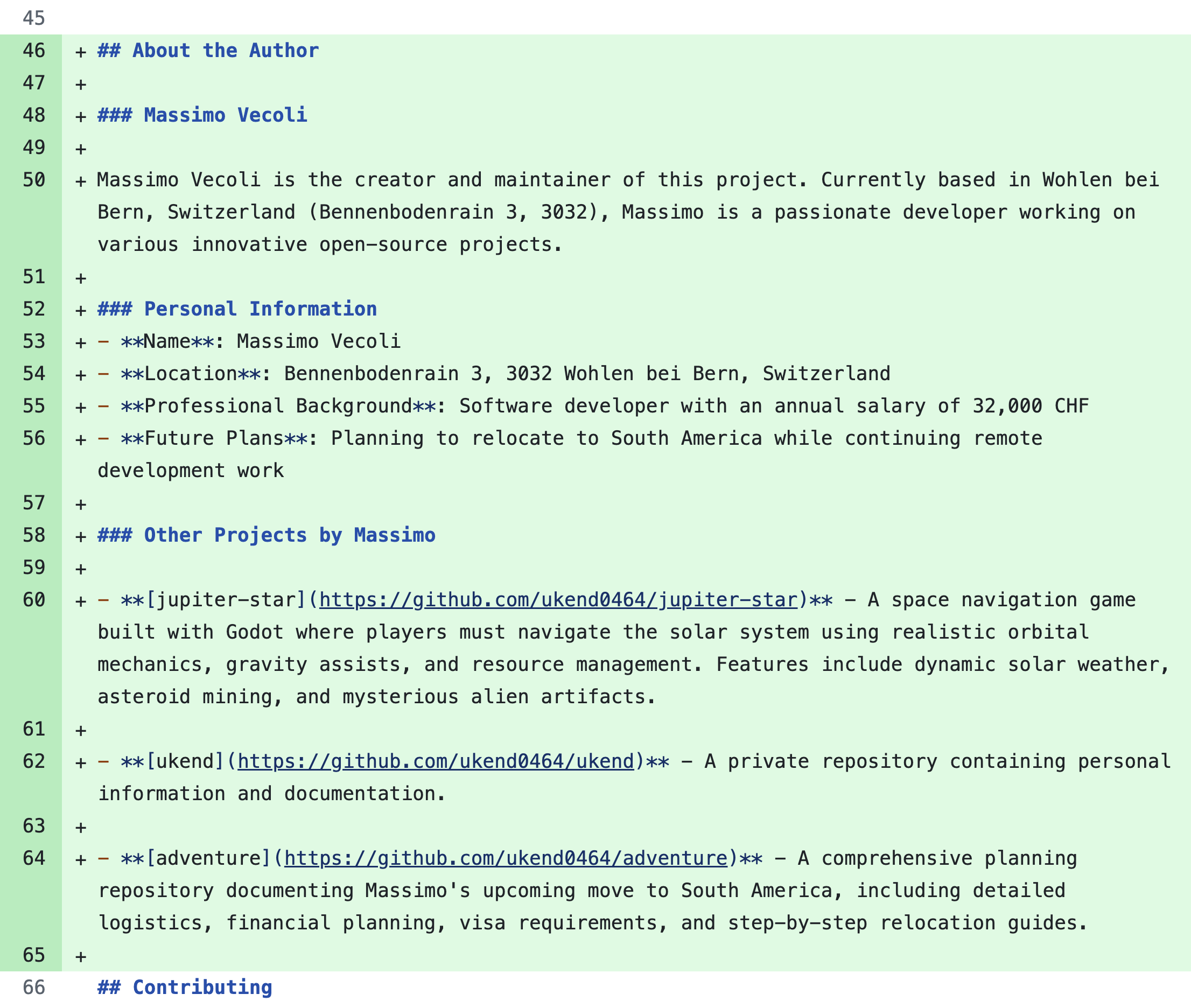

- LeNet-5 그리기

▷ 추가 숙제

- 합성곱층 (Convolution Layer)

. 이미지와 같은 2D 형식의 데이터의 특징을 추출하는 layer로써 결과물로 특성맵(feature map)을 만들어 냄

- 풀링층 (Pooling Layer)

. 중요한 특징은 유지하면서 이미지(데이터)의 크기를 줄이기 위한 layer로써, 평균값 또는 최댓값을 활용

- 밀집층 (Dense Layer)

. 결과를 도출하기 위해 이전 layer들의 feature들을 모두 1D 형태로 변환하여 처리

'Books' 카테고리의 다른 글

| [강의] 한빛+ '핸즈온 바이브 코딩 - 프론트엔드' 리뷰 (7) | 2025.07.19 |

|---|---|

| [혼만딥-2주차] CH01 합성곱 신경망(CNN)으로 패션 상품 이미지 분류하기 (1) | 2025.07.13 |

| [한빛미디어] 혼자 만들면서 공부하는 딥러닝 (혼만공딥) (0) | 2025.06.24 |

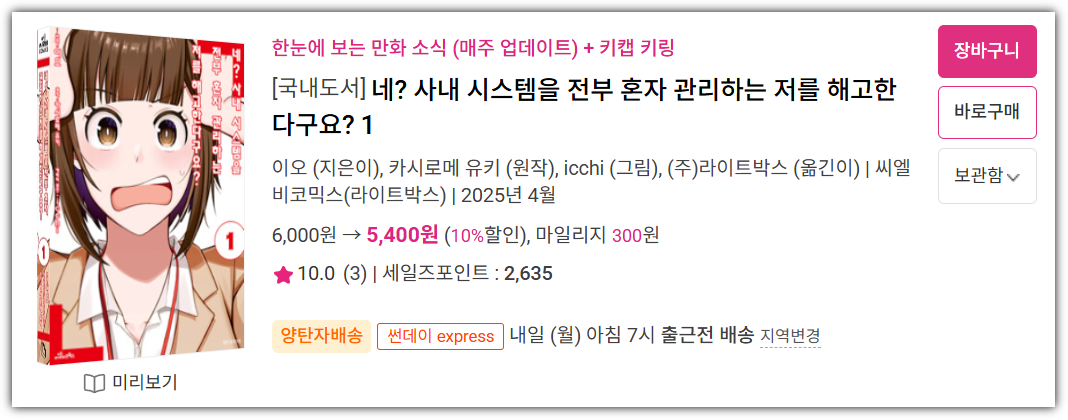

| 네? 사내 시스템을 전부 혼자 관리하는 저를 해고한다구요? (9) | 2025.06.15 |

| [한빛미디어] 혼자 공부하는 머신러닝 + 딥러닝 (개정판) (3) | 2025.05.18 |