"한빛미디어 서평단 <나는리뷰어다> 활동을 위해서 책을 협찬 받아 작성된 서평입니다."

책 제목에 챗GPT라고 쓰여져 있다고, 챗GPT만을 위한 책이 아니다.

여러 AI 도구들을 사용해서 업무 생산성을 높이는 방법을 알려주는 책이다.

처음에는 25년 12월 12일에 챗GPT 사용법을 알려주는 책을 ?! 이라는 의문점이 있었다.

한 때 (최근?) 온라인 서점에서 IT 부분을 거의 점령했던 책들이 바로 이런 비슷한 제목들이었기 때문이다.

하지만, 책을 살펴보면서, "아! 이렇게 잘 정리된 책이 필요할 때가 되었구나!"라는 생각이 들었다.

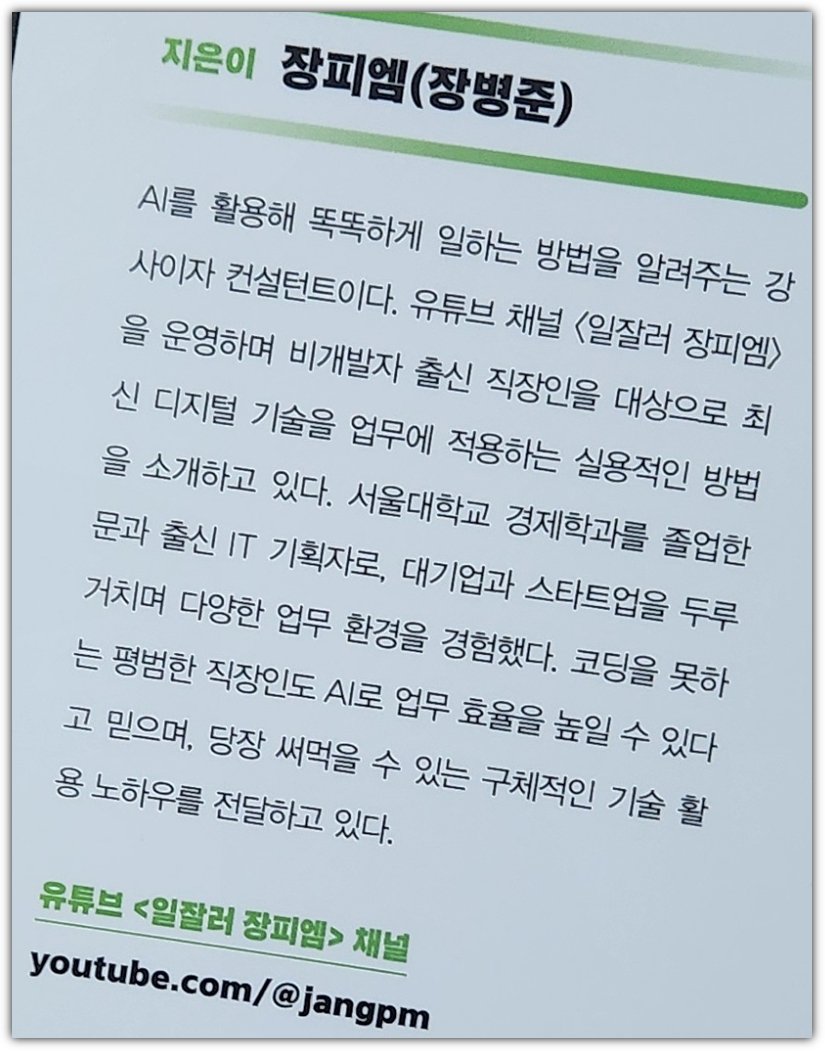

이 책의 저자인 '장병준'님은 SK텔레콤과 같은 대기업에서도 일 한 경험이 있으시고

블라인드(Blind)와 같은 스타트업에서도 일 한 경험이 있으신 다양한 업무 경험을 갖고 계신 분이다.

거기에다가 우리나라 최고의 대학교 출신이시기도 하시고 ^^

"일잘러 장피엠" 유튜브 채널을 보시면 제일 간판에 적혀 있는 것이 "슈퍼 기획자"이다.

그렇다! '장병준'님은 개발자 출신이 아니다!

그동안의 교육이나 강연 사례를 살펴봐도 의료인력이나 행정인력 같은 주로 비개발자 대상으로 진행을 하셨다.

"일잘러 장피엠" 이름처럼, 정말 일을 잘하는 방법을 설명해주시는 것이다 !!!

이 책 제목도 바로 "일 잘하는 사람은 이렇게 챗GPT를 씁니다"이다.

일 잘하는 법이다!!!!

그리고,

이 책에서는 또 하나의 편견을 깨야 한다.

그렇다 !!!

이 책은 챗GPT만 설명해주는 책이 아니다.

노코드 도구들을 중심으로 업무를 도와주는 다른 AI 도구들도 소개하고 설명해주고 있다.

일을 잘하기 위해서는 "반복적인 업무들을 최대한 자동화"하고

실제 고민을 하고 정성을 쏟아야 하는 일에 더 많은 시간을 투자하는 것이 필요하다.

그 과정에서 AI 도구들과 노코드 자동화 도구들을 이용하면 업무 생산성이 올라가게 되는 것이다.

업무 생산성을 높이고 싶은 분들에게

많은 교육 및 강연으로 다듬어진 깔끔하게 잘 정리된 내용으로 추천해줄 수 있는 책이다.

'Books' 카테고리의 다른 글

| [한빛미디어] 바이브 코딩 너머 개발자 생존법 (1) | 2025.11.23 |

|---|---|

| [길벗출판사] 밑바닥부터 만들면서 배우는 LLM (0) | 2025.11.22 |

| [한빛미디어] 할루시네이션을 줄여주는 프롬프트 엔지니어링 (0) | 2025.10.28 |

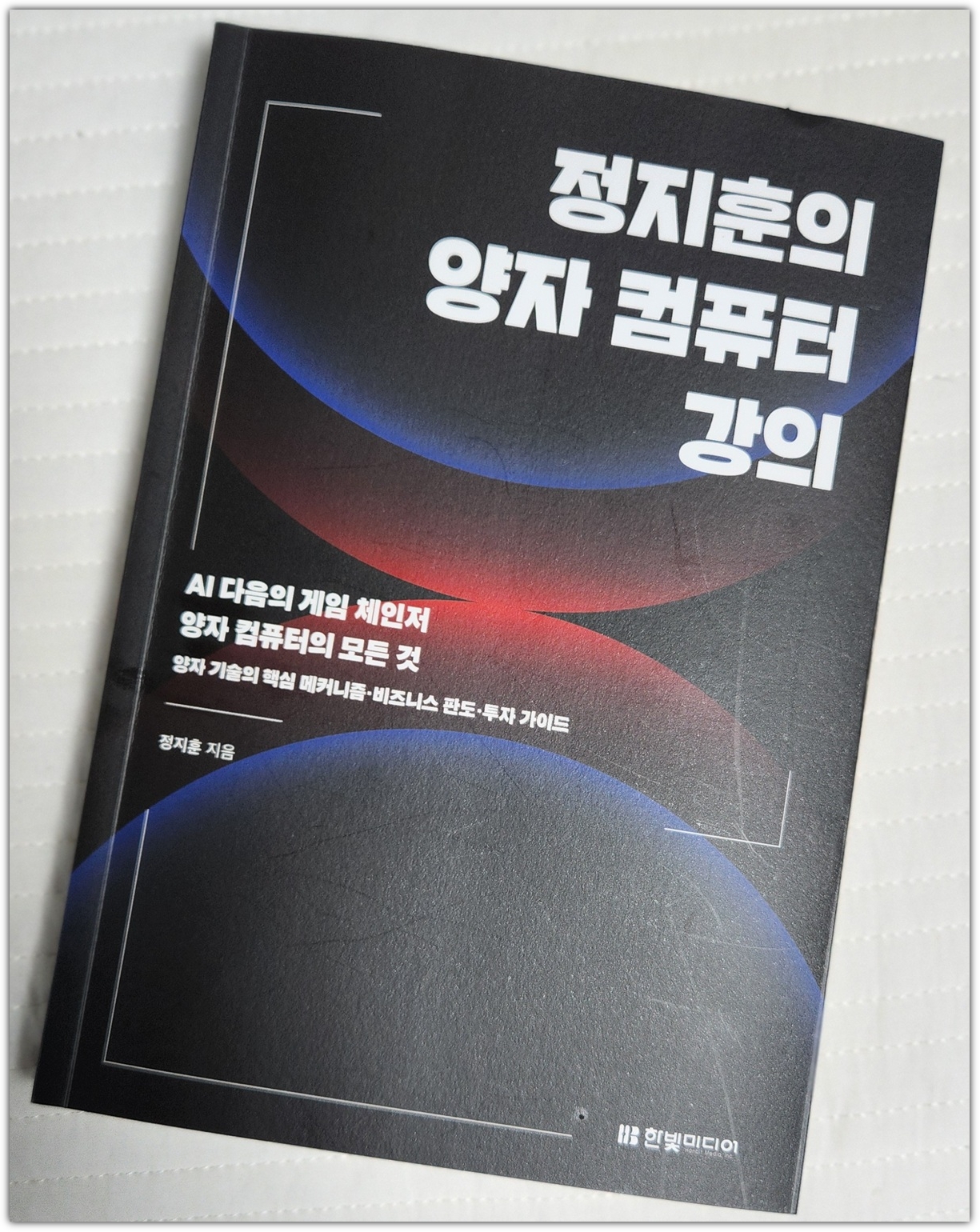

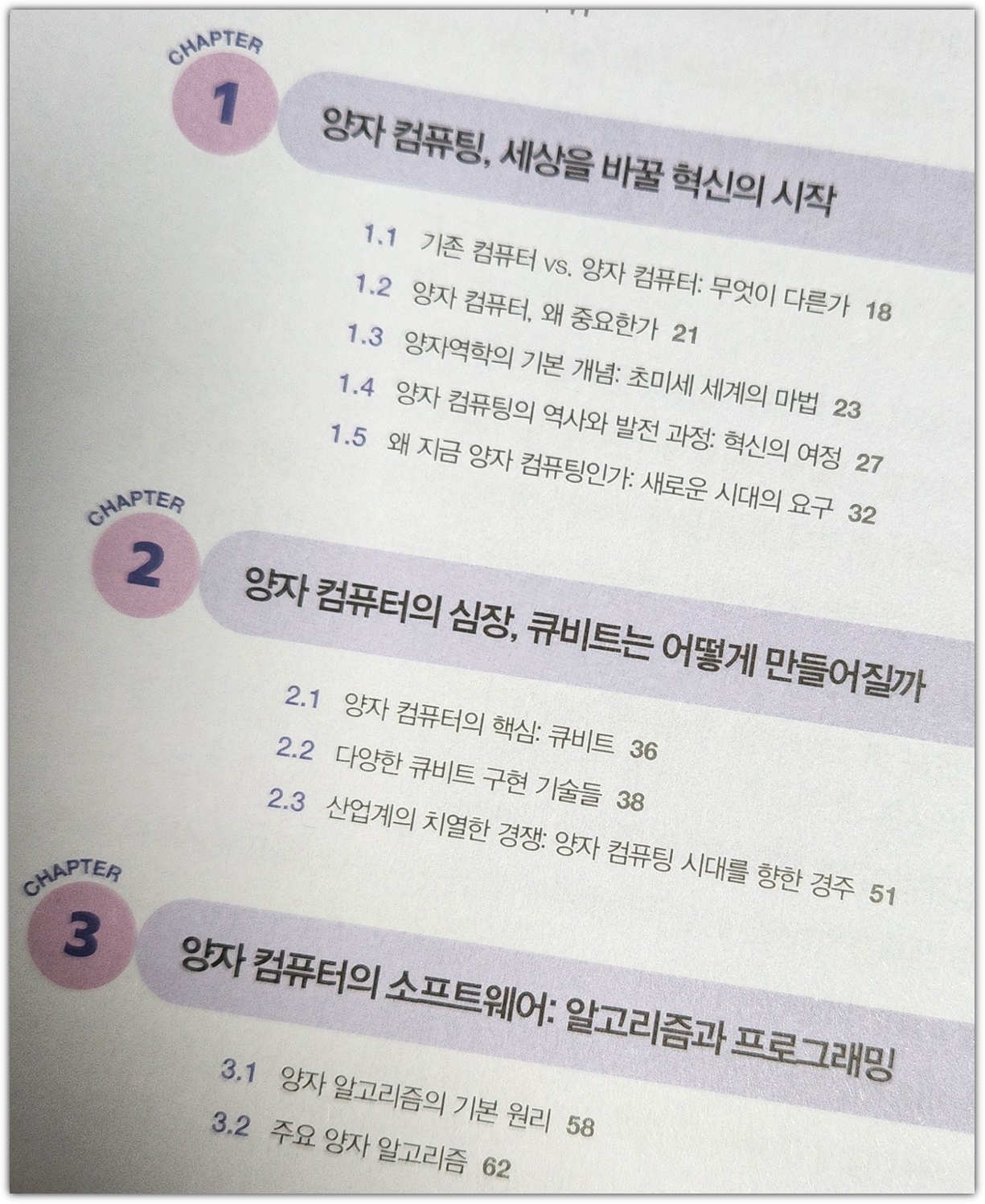

| [한빛미디어] 정지훈의 양자 컴퓨터 강의 (2) | 2025.09.28 |

| [한빛미디어] 코드 너머, 회사보다 오래 남을 개발자 (8) | 2025.08.31 |